„Mit 49 Eigenschaften lässt sich jedes Objekt charakterisieren“

Dr. Martin Hebart, Leiter der Forschungsgruppe "Visuelle Wahrnehmung und computergestützte Kognitionsforschung"

Herr Hebart, um was geht es in Ihrer Forschung genau?

In unserer Forschung wollen wir prinzipiell verstehen, an welchen Merkmalen wir das festmachen, dass wir ein Objekt als solches erkennen und wie wir sinnvoll damit interagieren können, zum Beispiel dass ich aus dem Glas vor mir trinken kann. Das klingt erstmal einfach. Es ist aber eine erstaunliche Fähigkeit, wenn man bedenkt, dass sich die Umgebung um uns herum ständig verändert und wir daher laufend neue Sinneseindrücke von Objekten wahrnehmen, die wir so noch nicht erlebt haben. Es läuft – quasi im Hintergrund – eine komplexe Abfolge an Wahrnehmungs- und Entscheidungsprozessen ab, durch die wir Eigenschaften erkennen und einteilen können, die ein Objekt ausmachen und es von anderen unterscheiden. Die Erkenntnisse aus unserer Forschung dienen hauptsächlich einem besseren Verständnis dieser Abläufe im menschlichen Gehirn. Sie können uns aber auch dabei helfen, bessere Verfahren der künstlichen Intelligenz zu entwickeln.

Inwiefern?

Bei selbstfahrenden Autos zum Beispiel. Der Fokus der künstlichen Intelligenzforschung liegt im Moment weitgehend auf der bestmöglichen Vorhersage. Dabei ist es irrelevant, wie genau Objekte von der künstlichen Intelligenz repräsentiert werden, also wie das Problem der Objekterkennung gelöst wird, solange sie richtig kategorisiert werden. Aktuelle Studien haben aber gezeigt, dass das in Situationen, die eine künstliche Intelligenz nicht so gut kennt, zu Problemen führen kann. Für ein selbstfahrendes Auto ist es zum Beispiel sehr wichtig zu erkennen, dass ein Ball auf der Straße bedeutet, ein Kind könnte in der Nähe sein. Trotzdem zeigen sicherlich die wenigsten Bilder, von denen diese Algorithmen das Fahren gelernt haben, Bälle auf der Straße. Wenn man also die Gemeinsamkeiten und Unterschiede bei der Repräsentation von Objekten im Menschen und der künstlichen Intelligenz besser versteht, kann das helfen, diese Algorithmen besser zu machen.

Wie wollen Sie die Erkennung von Objekten untersuchen?

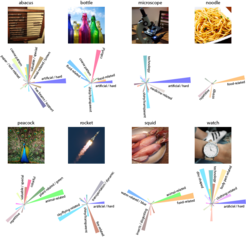

Um Objekte besser zu verstehen, mussten wir erst einmal ein ganz allgemeines Problem lösen: Welche Objekte gibt es überhaupt, und welche benutzen wir, um diese Vielfalt möglichst gut beschreiben zu können? Zunächst kamen wir auf etwa 7000 Begriffe für Dinge. Die haben wir dann eingedampft auf die Wörter, die wirklich als Bezeichnungen verwendet werden. Ein „Karpfen“ flog etwa wieder raus, weil der von Probanden eher als „Fisch“ bezeichnet wurde. Wir stellten fest, mit rund 2000 Benennungen, also Kategorien, lässt sich die Welt ziemlich gut beschreiben. Die nächste Herausforderung war: Wie finden wir Bilder von diesen Objekten, die wir unseren Versuchsteilnehmern zeigen können? Dazu durchstöberten wir Bildsuchmaschinen im Internet und sammelten von jeder Kategorie etwa 12 bis 15 Abbildungen. Insgesamt hatten wir rund 26.000 Dateien. Die haben wir alle ins gleiche Format gebracht und in eine große Datenbank aus Bildern aller Objekte zusammengestellt, die jetzt auch anderen Forschern frei zur Verfügung steht. Darauf aufbauend haben wir verschiedene Studien laufen, von Verhaltensexperimenten bis zur Messung von Aktivitätsmustern im Gehirn als Antwort auf die Bilder. Diesen Ansatz unterstützen wir mit computergestützten Modellen aus der künstlichen Intelligenzforschung wie tiefen neuronalen Netzwerken, die, vereinfacht gesagt, aus einer großen Mengen künstlicher Neurone bestehen, die in vielen Schichten angeordnet sind. Diese Modelle sind ganz grob dem Gehirn nachempfunden und zurzeit die besten Modelle, die wir von der visuellen Verarbeitung im Gehirn haben.

Was haben Sie hier schon herausgefunden?

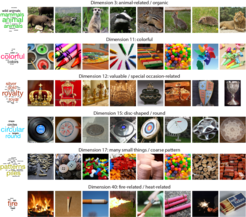

Gerade haben wir die Ergebnisse einer großen Verhaltensstudie zur Publikation eingereicht, mit denen wir erklären, anhand welcher Eigenschaften wir die etwa 2000 Objekte am ehesten charakterisieren würden. Letztlich haben sich rund 50 sogenannte Kerneigenschaften herauskristallisiert, anhand derer wir alle Objekte erkennen und in Kategorien zusammenfassen können, die also der sogenannten Repräsentation dieser Objekte zugrunde liegen. Die meisten Leute sind sich zum Beispiel einig darin, dass sich ein Tintenfisch und eine Garnele einander ähnlicher sind als es etwa zu einem Auto. Sie teilen mehr wesentliche Eigenschaften miteinander – sie sind Lebewesen, man kann sie essen, sie haben einen starken Bezug zu Wasser, und sie sind eher glibberig. Mit nur 49 Eigenschaften lässt sich also jedes der Objekte sehr gut charakterisieren, so gut, dass wir es mit unseren Daten fast nicht besser erklären können. Das finde ich schon sehr spannend.

Und wie soll’s weitergehen?

Wir haben vor einigen Monaten eine Studie gestartet, in der wir herausfinden wollen, ob sich unsere 26.000 Objekte in der Hirnaktivität widerspiegeln. Seit etwa fünfzehn Jahren weiß man, dass man aus den Aktivitätsmustern im Gehirn ablesen kann, welches Objekt eine Person gerade betrachtet. Gedankenlesen ist also schon in rudimentärer Form möglich (lacht). Das „Auslesen“ von Information aus dem Gehirn ist aber nicht der Fokus unserer Forschung. Wir wollen entschlüsseln, warumdiese Aktivitätsmuster so aussehen, wie sie aussehen. Welche Eigenschaften spielen also für unser Gehirn eine Rolle. Um diese Frage zu beantworten, wollen wir auch verschiedene Eigenschaften wie die Farbe, die Form oder auch „hat was mit Natur zu tun“, „kann sich bewegen“, „wertvoll“ oder „irgendwas mit Feuer“ als verbindende Elemente heranziehen. Ich bin der Meinung, dass wir nur durch das Aufdecken dieser Eigenschaften wirklich verstehen können, wie das Gehirn Objekte verarbeitet. Es ist zwar nicht garantiert, dass alle Eigenschaften so viel Sinn ergeben wie die, die wir in unseren bisherigen Verhaltensaufgaben gefunden haben. Aber damit sind wir natürlich umso gespannter, was wir entdecken.

Das Interview führte Verena Müller.