Wie wir unser Wissen über die Welt abrufen

Damit wir uns in der Welt zurechtfinden, ordnen wir sie in Konzepte ein, etwa in das Konzept „Telefon“ oder „Katze“. Bislang war jedoch unklar, wie das Gehirn diese abruft, wenn wir die Objekte nicht direkt sehen, hören oder fühlen, sondern allein ihre Bezeichnung fällt. WissenschaftlerInnen des Max-Planck-Instituts für Kognitions- und Neurowissenschaften haben nun ein Modell entwickelt, wie das Gehirn abstraktes Wissen verarbeitet. Dabei zeigte sich: Je nachdem, auf welche Merkmale man sich konzentriert, treten die entsprechenden Hirnregionen in Aktion.

Um die Welt zu verstehen, ordnen wir die einzelnen Objekte, Menschen und Ereignisse in verschiedene Kategorien oder „Konzepte“. Konzepte wie Telefon bestehen vor allem aus sichtbaren Merkmalen, also Form und Farbe, sowie Geräuschen, etwa Klingeln. Dazu kommen Handlungen, also wie wir ein Telefon benutzen.

Um die Welt zu verstehen, ordnen wir die einzelnen Objekte, Menschen und Ereignisse in verschiedene Kategorien oder „Konzepte“. Konzepte wie Telefon bestehen vor allem aus sichtbaren Merkmalen, also Form und Farbe, sowie Geräuschen, etwa Klingeln. Dazu kommen Handlungen, also wie wir ein Telefon benutzen.

Das Konzept Telefon entsteht im Gehirn aber nicht nur, wenn wir ein Telefon vor uns haben. Es zeigt sich auch, wenn lediglich der Begriff fällt. Lesen wir also das Wort „Telefon“, ruft unser Gehirn ebenfalls das Konzept Telefon ab. Dabei werden im Gehirn dieselben Regionen aktiv, die anspringen, würden wir ein Telefon tatsächlich sehen, hören oder benutzen. Das Gehirn scheint also die Merkmale eines Telefons zu simulieren, wenn allein seine Bezeichnung fällt.

Bislang war jedoch unklar, ob jeweils das gesamte Konzept Telefon abgerufen wird oder lediglich, je nach Situation, einzelne Merkmale wie Geräusche oder Handlungen – und ob entsprechend nur die Hirnareale aktiv werden, die das jeweilige Merkmal verarbeiten. Denken wir also bei einem Telefon immer an all seine Merkmale oder nur an den Teil, der gerade benötigt wird? Fragen wir bei einem klingelnden Telefon unser Geräuschwissen ab, bei der Benutzung aber das Handlungswissen?

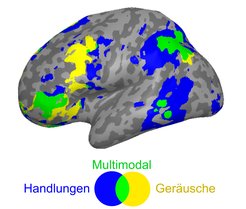

ForscherInnen des Max-Planck-Instituts für Kognitions- und Neurowissenschaften in Leipzig haben jetzt in einer großangelegten Studie herausgefunden: Es kommt auf die Situation an. Sollten die StudienteilnehmerInnen etwa bei dem Wort „Telefon“ an die damit verknüpften Geräusche denken, wurden die entsprechenden auditorischen Areale in der Großhirnrinde aktiv, die auch beim eigentlichen Hören anspringen. Ging es darum, an die Benutzung eines Telefons zu denken, traten die somatomotorischen Areale in Aktion, die auch die tatsächlich durchgeführte Handlung verarbeiten würden.

Zusätzlich zu diesen von Sinneseindrücken abhängigen, den sogenannten modalitätsspezifischen Arealen zeigte sich, dass es Areale gibt, die beides gemeinsam verarbeiten – Geräusche und Handlungen. Eines dieser sogenannten multimodalen Areale ist der linke Lobus parietalis inferior (IPL). Der wurde aktiv, wenn beide Merkmale abgefragt wurden.

Und nicht nur das: Die ForscherInnen fanden auch heraus, dass es neben Merkmalen, die auf Sinneseindrücken und Handlungen basieren, noch andere Kriterien geben muss, anhand derer wir Begriffe verstehen und einsortieren. Das zeigte sich, als die TeilnehmerInnen lediglich unterscheiden sollten, ob es sich um echte oder erfundene Wörter handelt. Hier sprang eine Region an, die weder für Handlungen noch für Geräusche zuständig ist: Der sogenannte anteriore Temporallappen (ATL). Der ATL scheint daher Konzepte abstrakt oder „amodal“ zu verarbeiten, völlig losgelöst von Sinneseindrücken.

Ein Modell für konzeptuelles Wissen

Aus diesen Erkenntnissen haben die WissenschaftlerInnen schließlich ein hierarchisches Modell entwickelt, das widerspiegeln soll, wie konzeptuelles Wissen im menschlichen Gehirn repräsentiert ist. Demnach werden Informationen von einer Hierarchieebene an die nächste weitergegeben und gleichzeitig bei jedem Schritt abstrakter. Auf der untersten Ebene liegen also die modalitätsspezifischen Areale, die einzelne Sinneseindrücke oder Handlungen verarbeiten. Diese übertragen ihre Informationen an die multimodalen Regionen wie den IPL, die mehrere verknüpfte Wahrnehmungen gleichzeitig verarbeiten, etwa Geräusche und Handlungen. Auf der höchsten Ebene arbeitet der amodale ATL, der von Sinneseindrücken losgelöste Merkmale repräsentiert. Je abstrakter dabei ein Merkmal, desto höher das Level, auf dem es verarbeitet wird und desto weiter ist es von eigentlichen Sinneseindrücken entfernt.

„Wir zeigen also, dass sich unsere Konzepte von Dingen, Menschen und Ereignissen zum einen aus den damit assoziierten Sinneseindrücken und Handlungen zusammensetzen und zum anderen aus abstrakten symbolartigen Merkmalen“, erklärt Philipp Kuhnke, Erstautor der zugrundeliegenden Studie, die im renommierten Fachmagazin Cerebral Cortex veröffentlicht wurde. „Welche Merkmale aktiviert werden, hängt stark von der jeweiligen Situation oder Aufgabe ab.“

In einer Folgestudie in Cerebral Cortex fanden die ForscherInnen zudem heraus, dass modalitätsspezifische und multimodale Regionen situationsabhängig zusammenarbeiten, wenn wir konzeptuelle Merkmale abrufen. Der multimodale IPL interagierte mit auditorischen Arealen beim Abrufen von Geräuschen, und mit somatomotorischen Arealen beim Abrufen von Handlungen. Dabei zeigte sich, dass die Interaktion zwischen modalitätsspezifischen und multimodalen Regionen das Verhalten der StudienteilnehmerInnen bestimmt: Je stärker diese Regionen zusammenarbeiteten, desto stärker assoziierten die TeilnehmerInnen die Wörter mit Handlungen und Geräuschen.

Untersucht haben die Wissenschaftler diese Zusammenhänge mithilfe verschiedener Wort-Aufgaben, die die TeilnehmerInnen lösten, während sie im funktionellen Magnetresonanztomographen (fMRT) lagen. Hier sollten sie entscheiden, ob sie das genannte Objekt stark mit Geräuschen oder Handlungen verbinden. Dazu zeigten ihnen die ForscherInnen Wörter aus vier Kategorien: 1) Objekte, die man mit Geräuschen und Handlungen assoziiert, etwa „Gitarre“, 2) Objekte, die man mit Geräuschen, aber nicht mit Handlungen assoziiert, etwa „Propeller“, 3) Objekte, die man nicht mit Geräuschen, aber mit Handlungen assoziiert, etwa „Serviette“, sowie 4) Objekte, die man weder mit Geräuschen noch mit Handlungen verbindet, etwa „Satellit“.